Livetranskription und -übersetzung von Vorträgen

Eine simultane, maschinelle Transkription und Übersetzung während Vorlesungen oder Konferenzbeiträgen kann in Lehre und Studium Barrieren abbauen und die Internationalisierung in der Wissenschaft unterstützen.

Kontext

In der Hochschullehre ebenso wie auf wissenschaftlichen Tagungen ist der mündliche Vortrag ein klassisches Präsentationsformat, etwa im Rahmen einer Vorlesung, als Gruppenpräsentation in einem Seminar oder als Konferenz-Keynote. Er richtet sich meist an eine größere Gruppe von Zuhörenden, die sich im selben Raum befinden und dem Vortrag synchron, also in Echtzeit, folgen. Ebenso können Vorträge aber auch räumlich verteilt über ein Videokonferenzsystem umgesetzt werden.

Problem

Personen ohne oder mit eingeschränkten Sprachkenntnissen, aber auch Gehörlose und Personen mit Hörbehinderung, haben teils große Probleme einem Vortrag zu folgen.

Rahmenbedingungen

- Flüchtigkeit des Gesagten: Hören findet immer in Echtzeit statt und die gehörten Signale sind flüchtig. Zuhörende haben also nur im Moment des Gesagten Zugang zu den Inhalten eines Vortrags.

- Einschränkungen der Zuhörenden: Zuhörende eines Vortrags können durch unterschiedliche Hürden Probleme damit haben, einem Vortrag zu folgen. Hürden können beispielsweise individuelle Hörbeeinträchtigungen sein oder eingeschränkte Sprachkenntnisse. Aber auch Störgeräusche in der Umgebung können das Zuhören erschweren. Die betroffenen Personengruppen verpassen dadurch gegebenenfalls wichtige Inhalte des Gesagten oder haben kaum Zeit, sich mit diesen auseinanderzusetzen, da das Hörverstehen einen Großteil ihrer kognitiven Ressourcen bindet.

- Barrierefreiheit: Die Inklusion aller Studierenden ist ein wichtiges Ziel für Lehre und Studium. Studierende mit studienrelevanten gesundheitlichen Einschränkungen sollten möglichst optimal unterstützt werden, um an Lehrveranstaltungen gleichberechtigt teilnehmen zu können.

- Internationalisierung: Der fachlich-inhaltliche Austausch mit Lernenden sowie Expertinnen und Experten auf internationaler Ebene wirkt sich positiv auf die Qualität von Lehre und Forschung aus. Dieser Austausch wird allerdings durch Sprachbarrieren erschwert, etwa wenn aktuelle Erkenntnisse zu einem Thema nur in Vorträgen in ausgewählten Sprachen dargestellt und diskutiert werden und keine muttersprachlichen Alternativen verfügbar sind.

- Ressourcen: Der Einsatz von Dolmetscherinnen und Dolmetschern für die Verschriftlichung oder Simultan-Übersetzung mündlicher Vorträge ist ressourcenintensiv und für regelmäßige Lehrveranstaltungen kaum zu leisten.

Lösung

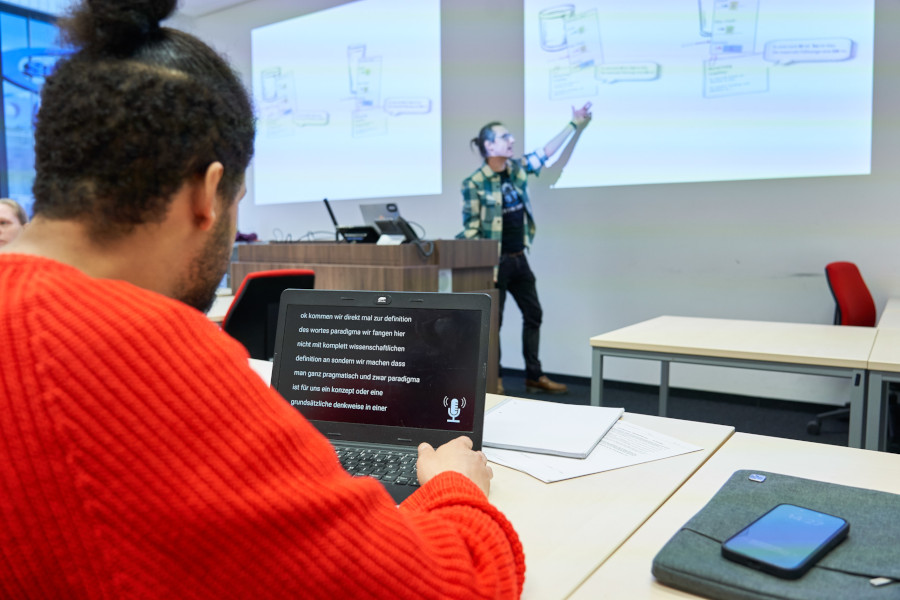

Der mündliche Vortrag einer Person wird über Mikrofon live aufgenommen und simultan über maschinelle Spracherkennung verschriftlicht. Dadurch kann das Transkript in Echtzeit im Internet bereitgestellt werden, so dass andere Personen, beispielsweise über ihre Mobilgeräte, darauf zugreifen können. Neben der Verschriftlichung kann auch eine maschinelle Übersetzung des Gesagten in andere Sprachen erfolgen und ebenfalls über das Internet bereitgestellt werden.

Details

Die maschinelle Verschriftlichung und Übersetzung des Gesagten wird allen Personen im Raum zum Abruf bereitgestellt und kann dann parallel zum Vortrag auf einem mobilen Endgerät mitgelesen werden. Ebenso können über ein Videokonferenzsystem zugeschaltete Personen das Transkript nutzen und es sich auf dem Bildschirm parallel zur Videoübertragung anzeigen lassen. Der Vortrag lässt sich dann nahezu wie ein Film mit Untertitelung verfolgen.

Werden während oder nach dem Vortrag auch Wortbeiträge aus dem Publikum beigesteuert, muss sichergestellt werden, dass diese ebenfalls verschriftlicht und übersetzt werden. Hierfür sollte ein Handmikrofon bereitliegen, dass mit dem System verbunden ist und konsequent für jeden Wortbeitrag verwendet wird. Alternativ kann, insbesondere in kleineren Räumen, auch ein feststehendes Mikrofon verwendet werden.

Der Zugang zum Transkript sollte niedrigschwellig erfolgen, beispielsweise über einen QR-Code, der im Raum angezeigt wird (detaillierte Informationen hierzu bietet der Text QR-Code-Verknüpfung). Je nach verwendeter Software kann der Zugriff auf das Transkript während sowie nach dem Vortrag zudem gezielt gesteuert und eingeschränkt werden, beispielsweise indem ein Kennwort für den Zugang zur Live-Übersetzung eingegeben werden muss.

Das Transkript in Originalsprache sowie gegebenenfalls in der jeweiligen Übersetzung lässt sich nach dem Vortrag dauerhaft digital zum Abruf bereitstellen. Wurde der Vortrag zudem als Video aufgezeichnet, empfiehlt es sich, das Transkript als optionale Einblendung parallel zum Video anzubieten.

Stolpersteine

- Die Teilnehmenden können sich nicht gleichzeitig auf das fortlaufende Transkript und die Handlungen der vortragenden Person fokussieren. Das Mitlesen des Transkripts bzw. der Übersetzung lenkt die Aufmerksamkeit weg von der vortragenden Person auf den Bildschirm der anzeigenden (Mobil-)Geräte. Dadurch besteht die Gefahr, dass begleitende Handlungen und Interaktionen der vortragenden Person, aber auch eingeblendete Folien nicht wahrgenommen werden. Um dieses Problem zumindest zu minimieren kann – abhängig von der Ausstattung des Vortragraums – die Transkription bzw. Übersetzung auf einem Bildschirm oder per Beamer neben oder über der vortragenden Person eingeblendet werden. Für die Teilnahme per Videokonferenzsystem lässt sich das Transkript zusätzlich zum Videobild der vortragenden Person in einem parallel einblendbaren Textfeld darstellen.

- Transkripte sind auch bei einer sehr guten Software nicht fehlerfrei. Zudem werden oftmals Satzzeichen sowie Groß- und Kleinschreibung nicht berücksichtigt. Aber auch bei einer höheren Fehlerrate können Transkripte das Verstehen noch unterstützen. Hier gilt es jeweils anhand der verfügbaren Software abzuwägen, wann das Transkript noch eine sinnvolle Unterstützung darstellt und welche Fehlerrate akzeptabel erscheint.

- Ein Live-Transkript hat nicht die sprachliche Qualität eines geschriebenen Textes. Ist für die langfristige Bereitstellung des Transkripts eine sehr gute sprachliche Qualität notwendig, muss eine Nachbearbeitung des Transkripts mit entsprechendem (Zeit-)Aufwand eingeplant werden.

Vorteile

- Personen mit Höreinschränkungen werden unterstützt, indem sie während eines Vortrags live mitlesen können. Auch Personen ohne Hörbeeinträchtigungen profitieren von einem Transkript, wenn die vortragende Person beispielsweise aufgrund von Umgebungsgeräuschen nicht gut zu hören ist.

- Sprachliche Hürden werden abgebaut, indem Zuhörenden der Vortrag als Übersetzung in einer individuell auswählbaren Sprache angeboten wird.

- Die Verschriftlichung (und gegebenenfalls Übersetzung) stellt eine Dokumentation des Gesagten dar, die Studierende beispielsweise nach Vorlesungen zur Nachbereitung nutzen können.

- Auch während des Vortrags können Stellen im Transkript bei Bedarf schnell nachgesehen und wiederholt werden.

- Der Zugriff auf die Transkription ist für die Nutzenden mit eigenen mobilen Endgeräten sehr einfach. Bei Veranstaltungen auf dem Campus fallen durch vorhandene kostenlose Internetzugänge keine zusätzlichen Kosten für die Datenübertragung an.

Nachteile

- Insbesondere bei der Übersetzung entsteht meist eine kleine Verzögerung, da Sätze erst vollständig ausgesprochen und transkribiert werden müssen, bevor sie zuverlässig übersetzt werden können. Dadurch kann es zu einem zeitlichen Versatz zwischen Aktionen des Vortragenden und der Bereitstellung des (übersetzten) Transkripts kommen. Wird ein Vortrag beispielsweise mit einer Veranschaulichung vor Ort, etwa einem Experiment, verknüpft, kann das Gesagte gegebenenfalls nur schwer exakt der dazugehörenden Aktion zugeordnet werden. Dies kann den Lernprozess beeinträchtigen.

- Die Transkription sowie die Simultanübersetzung sind nicht perfekt, d.h. eine gewisse Fehlerrate muss auch bei sehr fortgeschrittenen Systemen der Spracherkennung, Textstrukturierung und Übersetzung toleriert werden. Einfache Programme zeigen schon deutliche Mängel aufgrund von Hintergrundgeräuschen, einer zu geringen Lautstärke der sprechenden Person oder bei sprachlichen Besonderheiten, wie Dialekt.

- Abhängig vom benötigten Leistungsumfang haben die eingesetzten Programme einen hohen Serverbedarf. Mobile Versionen, die nicht lokal auf eine Server-Struktur der Hochschule zugreifen, bieten deshalb oft nur ein begrenztes Leistungsspektrum, z.B. keine simultane Übersetzung oder eine Beschränkung auf wenige verfügbare Sprachen.

Werkzeuge

Einige Videokonferenzsysteme, wie ZOOM, verfügen über eine integrierte Transkriptionsfunktion, mit der Meetings oder Webinare simultan untertitelt werden können. Teilweise können hier auch Untertiteldienste von Drittanbietern eingebunden werden. Allerdings ist die Genauigkeit der angebotenen Transkriptionsfunktion oftmals sehr eingeschränkt.

Beispiele

- Das Karlsruher Institut für Technologie (KIT) setzt in Vorlesungen den Lecture Translator, eine IT-Infrastruktur zur maschinellen Spracherkennung und Übersetzung, ein. Der Lecture Translator ist am KIT in vielen Hörsälen sowie als mobile Version verfügbar und kann jeweils auch mit einer Vorlesungsaufzeichnung verbunden werden. Am KIT sollen mit dem Angebot deutschsprachige Studiengänge für ausländische Studierende erschlossen sowie insgesamt die Barrierefreiheit verbessert werden.

- Am Nara Institute of Science and Technology (NAIST) in Japan wurde ein Deep-Learning-System entwickelt, mit dem Vorlesungen aus dem Japanischen ins Englische übersetzt werden können. Zwar ist auch hier eine simultane Verschriftlichung und Übersetzung möglich, das System wird allerdings bevorzugt für die Untertitelung von Videoaufzeichnungen der Vorlesungen verwendet, da dabei die sprachliche Genauigkeit sehr viel größer ist.

- Das Fraunhofer Institut für Intelligente Analyse- und Informationssysteme (IAIS) hat einen KI-basierten Spracherkenner entwickelt, der eine Simultan-Transkription in unterschiedlichen Kontexten ermöglicht. Er wurde bereits im Sächsischen Landtag für die Live-Untertitelung von Übertragungen der Plenarsitzungen verwendet und wird beispielsweise auch durch öffentliche Rundfunkanstalten, wie ARD oder WDR, eingesetzt. Der Spracherkenner kann sowohl lokal auf einer Standard-Server-Architektur installiert als auch cloudbasiert genutzt werden.